Sokaknak elsőre futurisztikus, távoli dolognak tűnhet a mesterséges intelligencia (MI), noha már szervesen beépült rengeteg olyan szolgáltatásba, amit nap mint nap használunk. Ott van a dugókat előre jelző, autókba épített navigációs rendszerekben, a Netflix vagy a Spotify ajánlórendszerei is algoritmusokat használnak, és a Facebook is rengeteg feladatot bíz algoritmusokra, kezdve a hírfolyam válogatórendszerétől a fotók elemzéséig. Naponta választunk olyan opciók közül, amiket a mesterséges intelligencia ajánl nekünk egyedi ízlésünkhöz és korábbi szokásainkhoz igazítva.

Mivel ezek a szolgáltatások jelentősen könnyítenek az életünkön, ritkán gondolunk bele minden lehetséges következménybe, jellemzően bizalmat szavazunk nekik. Mi is rendszerint hírt adunk arról, milyen területen hoz áttörést és pozitív eredményeket a mesterséges intelligencia használata, legyen szó nyomozások során történő felhasználásról, vagy betegségek korai felismeréséről.

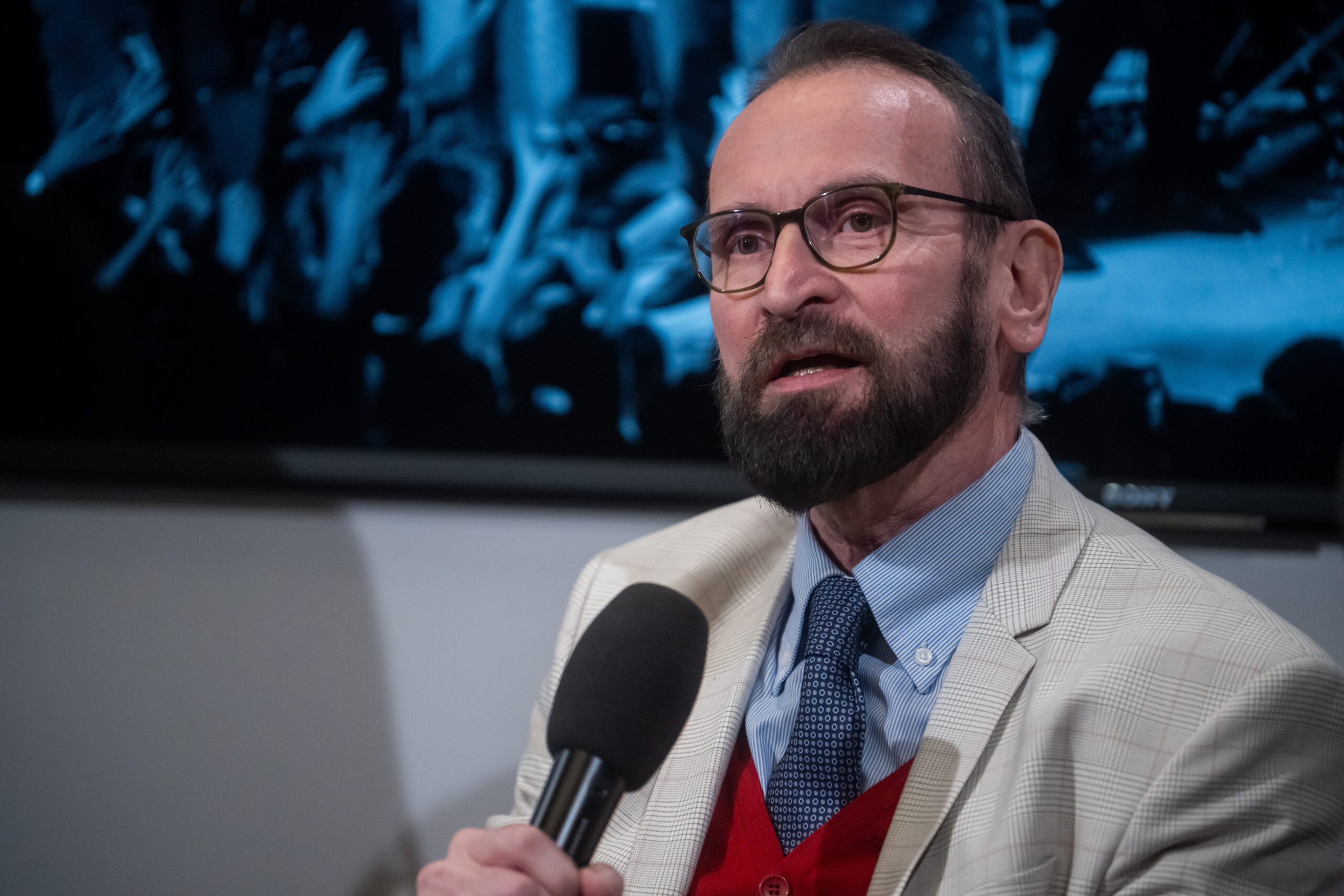

Ám az MI-nek is vannak árnyoldalai, és bár még korántsem értünk el a fejlettség végső szintjére, már most bőven akadnak olyan etikai aggodalmak, amelyekkel kapcsolatban sürgősen le kell fektetni a jogi alapokat és szabályokat. Ez volt a dublini Digital Summit egyik kiemelt témája: John Frank, a Microsoft uniós kormányzati ügyeiért felelős elnöke is beszélt a mesterséges intelligenciával kapcsolatos aktuális aggodalmakról.

Arcfelismerés a célkeresztben

A mesterséges intelligenciával kapcsolatos etikai aggodalmak nem újkeletűek, nemrég írtunk arról, hogy a Google egykori mérnöke például attól tart, hogy a gyilkos autonóm robotokig juthatunk. A keresőcég pár évig részt vett az Egyesült Államok Védelmi Minisztériumával közösen futtatott Project Maven nevű kezdeményezésben, amin belül olyan gépi tanulásos rendszeren dolgoztak, amivel meghatározható lett volna különböző objektumok, személyek elhelyezkedése a katonai drónok felvételein. A Google-nek viszont éles tiltakozással kellett szembenéznie az alkalmazottak részéről, akik közül rengetegen kifogásolták a drónfelvétel-elemző projektet, hiszen azt hadászati célokra vetették volna be a harcmezőn.

Az emberi intelligenciát meghaladó, önjáró robotokon felül az utóbbi években előtérbe került az arcfelismerő szoftverek ügye is. Elsősorban annak kapcsán, hogy Kínában a megfigyelés szerves részévé váltak azok a térfigyelő kamerák, amelyek személyek beazonosítására is képesek. Bár az elsődleges cél a rejtőzködő bűnözök felismerése, felvetődik annak a kockázata, hogy az elnyomó hatalmak kisebbségek monitorozására használják fel az űttörő technológiát.

Épül az ország, ahol senki nem bújhat el a kormány elől

Kínában egyre fejlettebb módszerekkel figyelik meg az embereket, és ez még csak a kezdet.

Világszerte több aktivista figyelmeztet arra, hogy az arcfelismerő szoftverek az elnyomó kormányok eszköztárának szerves részévé válhatnak. John Frank szerint amellett, hogy bűnözők kutathatók fel vele, ugyanúgy felhasználhatók például aktivisták és disszidánsok azonosítására is. De veszélyben lehetnek a stigmatizált és üldözött csoportok, történjen az vallás, etnikai hovatartozás, szexuális orientáció mentén, ez a tevékenység pedig sértené az alapvető emberi jogokat.

A nem kívánt, azonnali szociális hatásokat a marginalizált csoportok érezhetik meg, és amint nő a társadalmi egyenlőtlenség, úgy a társadalom szerkezete is veszélybe kerül, zavargások és forradalmak törhetnek ki - hívja fel a figyelmet a szakember. Képzeljük csak el, hogy egy kormány minden lépésünket követi a tudtunk vagy hozzájárulásunk nélkül, vagy hogy egy adatbázisban benne van mindenki, aki adott tüntetésen jelen volt - rengeteg a lehetőség a technológiával történő visszaélésre.

Persze Kínán kívül is akadnak példák az ilyen jellegű programok használatára. Az Egyesült Királyságban egyre gyakrabban alkalmaznak arcelemző szoftvereket az üzletekben, múzeumokban és konferenciatermekben, Németországban pedig a Südkreuz vasútállomáson aktív egy arcfelismeréses rendszer, amit élesen kritizálnak a jogászok és az adatvédelmet kiemelten kezelő csoportok.

Az arcfelismerés körül kialakuló vita is mutatja, égető az igény arra, hogy a szabályozók nagyobb figyelmet szenteljenek a kérdésnek. Az etikus használathoz pedig az iparban standarddé váló irányelvekre és szilárd jogi alapokra van szükség. Bár sokan mondják, hogy hova a sietség, hiszen még csak az út elején járunk, épp ezért nem szabad várni, a tét túlságosan nagy.

Ott a lehetőség, hogy az algoritmus is hibázik

Emellett a techcégeknek is nagyobb felelősséget kell tanúsítaniuk a saját szolgáltatásaik tervezésekor. A Microsoft már megfogalmazott fő irányelveket, amik mentén az etikai szempontoknak is megfelelő szolgáltatásokat lehet tervezni. A két fő elem a pártatlanság és a megbízhatóság: ez azt jelenti, hogy az MI-rendszereknek minden embert egyenlőként kell kezelnie, mindenkinek előnyöket kell kínálnia. A megbízhatóság és pontosság kérdése is fontos, lévén az algoritmus sem tökéletes. Gyorsan fejlődnek ugyan a rendszerek, de még messze vannak a tökéletestől.

A kutatók szerint nagy eséllyel akkor pontatlan a felismerés, ha kisebbségekről vagy nőkről van szó, ami növeli a hibák számát. Ennek oka abban rejlik, hogy milyen arányban és milyen adatokon keresztül képezik ki a gépi tanulásos algoritmust - amennyiben a forrásként bevitt adathalmaz nem pontos és nem reprezentatív, a végeredmény sem lesz az.

Mindenkit kifehérít a rasszistának bélyegzett szelfiszerkesztő

Barack Obamának nemcsak babapofit, de világosabb bőrt is varázsol a szépítő funkció.

Jó példa erre, hogy 2017-ben a FaceApp nevű képszerkesztőt erős kritika érte, amiért a szépítő funkció a sötétbőrűeket kifehérítette. A FaceApp alapítója utólag elárulta, hogy a neurális hálózat kiképzéséhez használt, betáplált referenciafotók miatt viselkedett így az szoftver. A moszkvai fejlesztők valószínűleg nem figyeltek oda a diverzitásra, amikor kiválogatták a fotókat, és mivel feltehetően több világos bőrszínű személy fotóját használtak fel, mint amennyi sötétbőrű embereket ábrázolt, ez kihatott a végeredményre is. Ez az eset is felhívja a figyelmet arra, hogy milyen kimenetele lehet, ha egy vizualitásra támaszkodó program nem kellően változatos adatbázis alapján készül.

Ezen a fejlesztők ugyan változtathatnak, de nincs bombabiztos módszer a szolgáltatások teljesítményének ellenőrzésére. Épp ezért fontos, hogy jogilag le legyen fektetve az átláthatóság követelménye, hogy a szolgáltatásokat fejlesztő cégek közzétehessék, milyen korlátaik és kapacitásuk van, miből tudnak dolgozni és mivel nem tudnak. A folyamatos teszteléshez pedig be kell vonni külső feleket is, akik pártatlanul tudják felderíteni a rendszerek hibáit.

Kiemelt kép: iStock