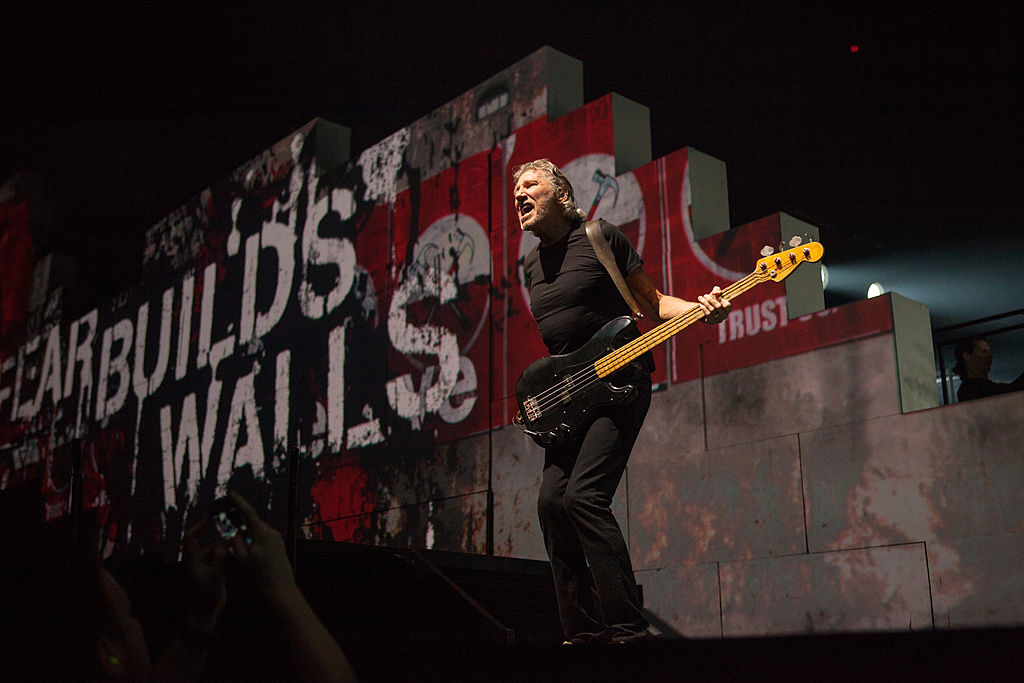

A gépi tanulási modell sohasem hallotta az Another Brick in the Wall című számot, csak a dalt meghallgató emberek agyhullámaiból rekonstruálta a felvételt.

Sokszor elgondolkodtam már azon, hogy miként lehetne örökül hagyni utódaimnak azt a rengeteg zenét, amelyet életemben hallgattam és amelyet magamban bármikor elő tudok hívni az agyamból. Lehet, hogy ez a vágy megvalósítható lesz a nem is olyan távoli jövőben. Erre mutat a kaliforniai Berkeley egyetem kísérlete. Egy mesterséges intelligenciával ugyanis sikerült egy felismerhető részletet reprodukálni a Pink Floyd Another Brick In The Wall című dalának első részéből.

Ehhez Robert Knight és kutató kollégái olyan elektródák jeleit használták fel, amiket 29 epilepsziás beteg agyába ültettek be sebészeti eljárással. A betegekkel meghallgattatták a Pink Floy dalát, majd megvizsgálták az agyműködésükről közben rögzített felvételeket. Úgy látták, hogy összefüggés van a szám hangmagassága, melódiája, harmóniája és ritmusa, valamint az agyműködésről készült felvételek között.

Ezt követően arra képeztek ki egy mesterséges intelligenciát, hogy találja meg az összefüggéseket az agytevékenység és a zenei alkotóelemek között, majd közvetlenül az emberi agykérgi felvételekből rekonstruálja a rock-történeti dal 15 másodpercét.

Az alábbi videó 7. másodpercétől az hallatszik, ahogy a kísérlet résztvevőinek lejátszák a zenét, majd a 16. másodperctől az, ahogy mindezt a mesterséges intelligencia visszaadja.

A kísérlet több volt egy öncélú demostrációnál. A kutatók beazonosítottak egy agyterületet a felső halántéki agytekervénynek nevezett régióban, amely feldolgozta a dalban elhangzó gitárjáték ritmusát. Megállapították továbbá, hogy az agy jobb féltekéjéből jövő jelek fontosabbak a zene felismerésében, mint a bal agyféltekéből eredőek, megerősítve ezzel korábbi tanulmányok eredményeit.

„Ha elmélyítjük tudásunkat azon a téren, hogy miként észleli az agy a zenét, tovább fejleszthetjük azokat az eszközöket, amelyek a beszédnehézségekkel küzdő emberek helyett beszélnek” – nyilatkozta Knight a New Scientistnek „Azok számára, akik amiotrófiás laterálszklerózisban (ALS) vagy afáziában szenvednek, olyan eszközt szeretnénk megalkotni, amely által emberi módon tudnának másokkal kommunikálni.”

Az amerikai kutató szerint el lehet jutni odáig, hogy megértsük: miként fogja fel az agy a beszéd zenei elemeit, beleértve a hangsúlyt és az érzelmeket. Ennek birtokában e beszédsegítő eszközök hangja kevésbé lenne robotszerű. Knight egyúttal elismerte, hogy az agyimplantátumokat invazív jellegük miatt aligha lehetne nem klinikai módon alkalmazni. De folynak más, hasonló irányú kísérletek is. A Cornell egyetemen nemrégiben mágneses rezonancia-képalkotás (MRI) agyjel-mintáiból alkottak mesterséges intelligenciával dallamtöredékeket.

Ha az AI képes agyjelekből rekonstruálni azt a zenét, amit az emberek elképzelnek, nemcsak azt, amit éppen hallgatnak, ezzel a módszerrel akár komponálni is lehet – vetítette előre a jövőt Ludovic Bellier, a berkeley-i kutatócsoport tagja.

Mások szerint azonban a mesterséges intelligencia által újraalkotott dalok szerzői jogi problémákat vethetnek fel.