A világon immár kétféle intelligencia létezik: az állati agy és a neurális hálózat. Vannak, akik szerint utóbbi az intelligencia új és jobb formája, ami aggasztó kérdéseket vet fel az emberiség jövőjével kapcsolatban.

Forradalmi hatása szempontjából az első iPhone megjelenéséhez hasonlította Demis Hassabis, a Google tulajdonában álló DeepMind vezetője az általános mesterséges intelligencia (artificial general intelligence, AGI) megjelenését, ami szerinte akár 10 éven belül megtörténhet. És ezzel még valószínűleg alá is becsülte a várható következményeket.

Korábban ennek a szintnek az elérését évtizedekre tették a kutatók. A ChatGPT megjelenésével azonban minden gyorsulni kezdett. A márciusban megjelent GPT-4-ről a Microsoft kutatói már azt mondták, hogy túllép azokon a kereteken, amelyekre kiképezték. Miközben meggyőzőek a nyelvi képességei, „az általános mesterséges intelligencia szikráit mutatja”.

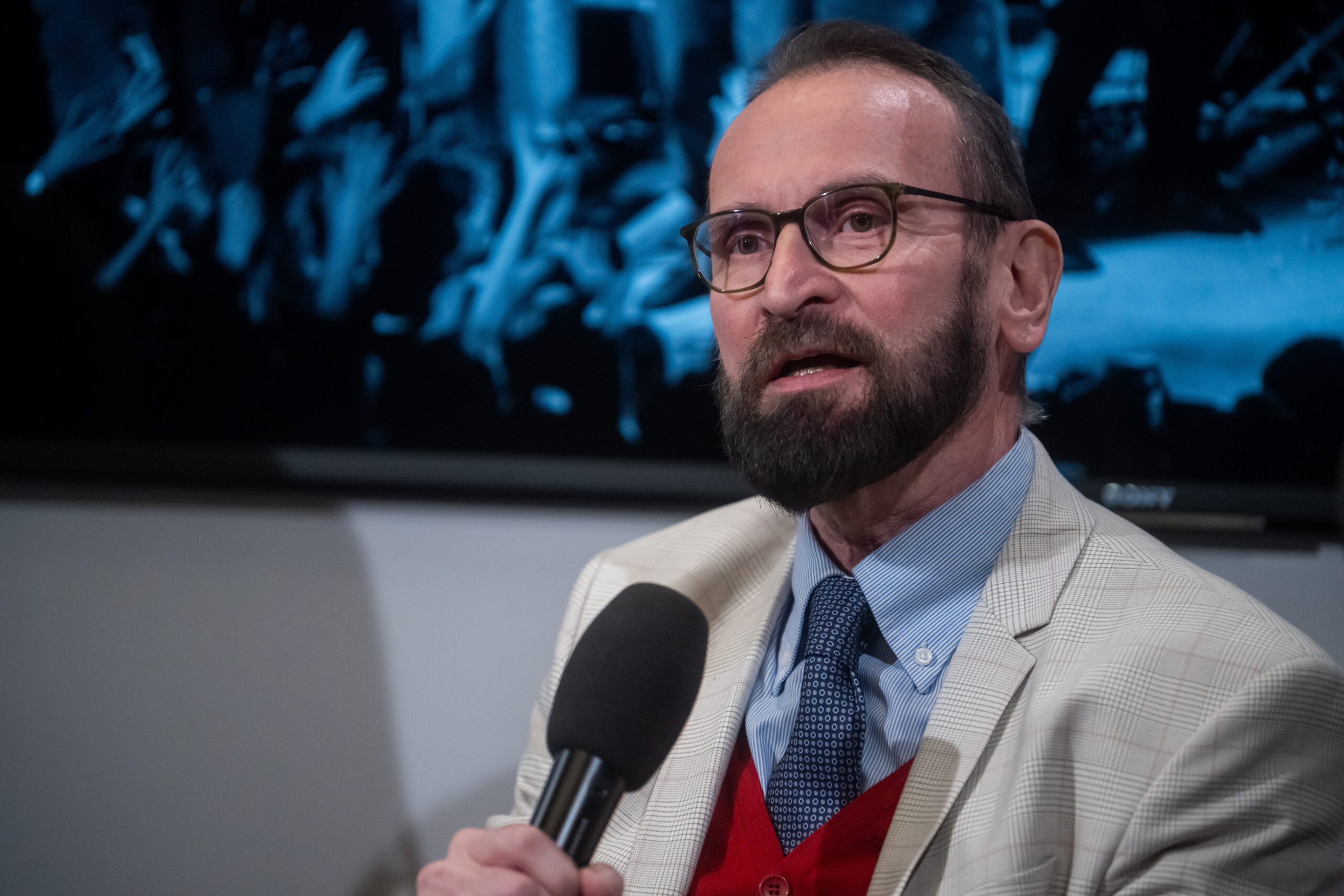

A közelmúltig a Google-nél dolgozó Geoffrey Hinton, aki a mélytanulással kapcsolatos munkájáért 2018-ban megkapta a világ egyik legrangosabb számítástechnikai díját, a Turing-díjat, nemrég azt mondta, komolyan félni kezdett a következményektől.

„Hirtelen megváltozott a véleményem arról, vajon ezek a dolgok intelligensebbek lesznek-e nálunk. Azt hiszem, már most nagyon közel állnak hozzá, és a jövőben sokkal intelligensebbek lesznek, mint mi. Hogyan éljük ezt túl?” - tette fel a kérdést az MIT lapjában.

– mondja.

Ennek bizonyítására két példát is felhoz.

„Ha mi tanulunk valamit, és át akarjuk adni ezt a tudást valaki másnak, akkor nem küldhetünk el neki egy példányt a saját tudásunkból. De lehet tízezer neurális hálózatom, mindegyik rendelkezhet saját tapasztalatokkal, és mindegyik egy szempillantás alatt megoszthatja a többivel a tanultakat. Ez óriási különbség. Mintha tízezren lennénk, és amint egy ember megtanul valamit, mindannyian tudjuk.”

Emellett szerinte az is a neurális hálózatok fölényét bizonyítja, hogy az emberi agynál jóval kevesebb kapcsolattal is fantasztikus dolgokra képesek.

„Agyunkban 100 billió kapcsolat van” – mondja Hinton. „A nagy nyelvi modellekben félbillió, legfeljebb egybillió van. A GPT-4 azonban százszor többet tud, mint bármelyik ember. Tehát talán valójában sokkal jobb tanulási algoritmusa van, mint nekünk.”

Yann LeCun, a Meta vezető mesterséges intelligencia-tudósa nem osztja Hinton félelmeit.

„Nem kérdés, hogy a gépek a jövőben okosabbak lesznek az embereknél” – mondja. „De az intelligens gépek az emberiség új reneszánszát, a megvilágosodás új korszakát nyitják meg.”

Szerinte abból, hogy valami okosabb nálunk, még nem következik, hogy uralni akar bennünket, vagy az elpusztításunkra tör.

A Stanford Egyetem áprilisi felmérésén mindenesetre az informatikusok és mesterséges intelligencia kutatók 56 százaléka úgy gondolta, hogy az AGI már valóság. A válaszadók 58 százaléka szerint aggódnunk kell miatta, 36 százalékuk pedig úgy vélte, nukleáris katasztrófához vezethet a létrehozása.

Azt írják, nyolc évtizeddel az atombomba kifejlesztésére irányuló példátlan erőfeszítés után ideje lenne egy új, hasonló méretű kormányzati projektet indítani. Csak ennek nem a korábban elképzelhetetlen pusztítás létrehozása, hanem épp ellenkezőleg, a pusztítás megelőzése lenne a célja.

Melanie Mitchellt, a Santa Fe-i egyetem professzora ugyanakkor eltúlzottnak érzi ezeket az aggodalmakat. A New Scientist kérdésére arról beszélt, jelenleg még azt sem tudjuk mérni, ténylegesen mennyire intelligensek a gépeink, mert nem rendelkezünk olyan egyértelmű teszttel, amivel megválaszolhatnánk ezt a kérdést.

Nemrégiben volt egy kísérlet, amelynek során a GPT-4-nek sikerült átmennie az Egyesült Államokban a jogi szakvizsgán. De ez vajon azt jelenti, hogy olyan intelligens ez a mesterséges intelligencia, mint egy jogász? Aligha.

Mitchell szerint a nagy nyelvi modelleket (LLM) igen nagy számú szöveges példákon képzik ki, ezáltal nagyon összetett asszociációkat tanulnak meg a különböző mondatokból, hogy egy szövegösszefüggésben kitalálják a soron következő szavakat.

Egy nyelvi modell képességeit alapvetően háromféle módon mérhetjük fel. Az egyik, hogy beszélünk hozzá, kérdéseket teszünk fel és figyeljük a reakcióit. Ez olyan, mint a Turing-teszt, amelynek alapkérdése: emberinek látszik-e ez a gép?

A másik módszer, hogy két mondatpárt adunk az AI-nek: az egyikben az első mondatból logikusan következik a második, míg a másikban a két mondat között nincsen logikai összefüggés. Az LLM-rendszerek általában nagyon jól tudják, hogy mely mondatok állnak egymással logikai kapcsolatban. De az is előfordul, hogy tévednek, mert nem úgy értik a mondatokat, ahogyan azt emberek értik, csak kifinomult statisztikai asszociációkat használnak.

Végül meg lehet vizsgálni magát a neurális hálózatot, megérteni azokat a mechanizmusokat, amelyekkel a gép megoldja a problémákat. De ez rendkívül nehéz, sőt, egyelőre szinte lehetetlen. A kutatók számára ezek inkább fekete dobozok, amikbe ténylegesen nem látnak be.

Megtévesztő lehet, hogy az LLM-ek ma már milyen sokféle feladatot képesek megoldani. Ha kell, számítógépes kódot írnak, matematikai számításokat végeznek, történeteket alkotnak, vagy regényhősök motivációit elemzik. Olyan látszatot keltenek, mintha képesek lennének bizonyos értelemben megérteni a világot, csupán azzal, hogy ember gyártotta szövegek tömkelegén edződtek.

Mitchell szerint az intelligenciának számos megnyilvánulási formája van. Az emberi intelligencia egészen más, mint például egy polipé, és más, mint egy generatív AI-é. Vannak, akik a „különböző intelligenciák” kifejezést használják, a kérdés, hogy miként jellemezzük őket, vannak-e közös vonásaik, vagy teljesen különböznek-e egymástól?

„Mi nemcsak nyelvi értést akarunk, hanem vizuálisát is, valamint azt is, hogy megértsünk egy adott helyzetet és helyesen cselekedjünk egy adott helyzetben”.

Az emberi intelligencia nagy része motivációinkra épül, azokat a célokat kell elérnünk, amelyeket az evolúció kitűzött számunkra. Ha a rendszernek nincsenek motívációi, nincsenek saját céljai, lehet, hogy nem is tudja elérni azt a fajta intelligenciát, amellyel mi rendelkezünk – véli a professzornő.

Az olyan nyelvi modelleknek, mint a GPT-4, ráadásul nincsen hosszú távú memóriájuk, nem gyűjtik össze a korábbi beszélgetéseket, tehát bizonyos értelemben nem törődnek azzal, hogy a múltban mit mondtak.

Hogy hová fejlődhetnek, azt szerinte nehéz megjósolni. Lehet, hogy felváltják az ügyvédeket, vagy segíthetik az orvosokat a diagnózis felállításában és a gyógyításban. De egyelőre számos korlátjuk van, jelenleg az LLM-ek nem rendelkeznek azzal a képességgel, hogy megkülönböztessék az igazat a hamistól. Ez pedig alapvető probléma.

Mitchell az AI-kutatások moratóriumára való felhívás kapcsán elismerte, hogy a technológia gyakran gyorsabban fejlődik, mint a szabályozás. Szerinte ezek a rendszerek lehetnek veszélyesek, terjeszthetnek előítéleteket, álhíreket, de nem hiszi, hogy a kutatások szüneteltetése lenne a helyes út. Szerinte inkább arra kellene figyelni, hogy milyen adatokkal képzik ki a mesterséges intelligenciákat. És nem lenne szabad hagyni, hogy az olyan cégek, mint az OpenAI azt mondhassák: bízzanak bennünk, tudjuk, mit csinálunk, de nem mutatjuk meg, nehogy a versenytársak belelássanak.

Míg a GPT-3-nál például még belenézhettek a kutatók a kiképző adatbankba, a GPT-4-nél már nincs ehhez hozzáférésük. Az OpenAI azt mondja, hogy mivel ez kereskedelmi termék, nem akarják előnyhöz juttatni a konkurenciát. Így viszont lehetetlen kutatni.

- mondja Mitchell.